Падение позиций сайта в выдаче может произойти по ряду причин. Важно изучить каждую из них, чтобы понять, почему статистика испортилась. В этой статье мы разберем 7 главных вопросов, которые стоит задать себе во время поиска причин понижения позиций сайта, и предложим решение наиболее распространенных проблем.

Изменились ли алгоритмы поисковых систем?

Разработчики Яндекса и Google регулярно обновляют правила, по которым ранжируются сайты, чтобы пользователь получал наиболее качественные результаты. Они изменяют важность определенных факторов ранжирования, вводят новые методы оценки контента и т.д.

Например, в 2025 году у Яндекса появился алгоритм «Тайфун». Он распознает некачественный контент, сгенерированный нейросетями, и хуже ранжирует страницы с ним. Цель нового алгоритма — защита пользователя от бесполезных ответов.

При анализе падения позиций рекомендуется сразу проверить историю обновлений поисковиков. Например, GSC Guardian для Chrome отображает информацию об апдейтах в Google Search Console.

Есть ли технические ошибки на сайте?

Качество работы сайта — это один из ключевых факторов ранжирования. Если страницы долго грузятся, есть дубли и битые ссылки, то занять хорошие позиции вряд ли получится. Обычно технические ошибки возникают после крупных обновлений CMS, плагинов, а также внешних атак.

Проверка ошибок сканирования в Google Search Console

Сайт должен индексироваться на 100%, кроме админки и страниц с закрытым доступом (например, личного кабинета пользователя). Вы можете проверить качество сканирования в Google Search Console. Для этого откройте раздел «Покрытие». Вы увидите отчет с 4 пунктами:

- Ошибка — критические проблемы сканирования.

- Без ошибок, есть предупреждения — адрес проиндексирован, но обнаружены некритичные ошибки.

- Страница без ошибок — корректно проиндексированные документы.

- Исключено — страницы, которые не индексируются.

Изменения в robots.txt и .htaccess

Нередко проблемы с индексацией связаны с халатностью SEO, веб-разработчика или администратора, который недавно работал с документами robots.txt и .htaccess. В них можно прописывать запреты на индексацию страниц и всего сайта. Если при настройке документа допустить ошибку, то поисковые роботы не смогут корректно работать с ресурсом.

Если ошибка заключается в robots.txt, то на страницах будет тег <meta name=’robots’ content=’noindex,nofollow’/>. Последние обозначения (noindex, nofollow) запрещают роботам индексировать страницы.

Также важно проверить отсутствие директивы SetEnvIfNoCase User-Agent в файле .htaccess. При ее появлении сайт буквально выпадает из выдачи.

Сломанные ссылки, редиректы и дубли

Это довольно распространенные проблемы. Они возникают при переезде сайта на новый хостинг, обновлении CMS и изменении структуры сайта. При обнаружении множественных нарушений поисковики пессимизируют ресурсы.

Поэтому после каждого обновления рекомендуется проверять состояние сайта с помощью Screaming Frog для поиска дублей, Xenu’s Link Sleuth для анализа ссылок и Redirect Checker для проверки редиректов.

Удален или изменен важный контент?

При существенном изменении и удалении контента трафик может существенно измениться. Динамика не всегда оказывается положительной, поэтому после внесения правок стоит проверять, как обновление сказалось на позициях сайтах.

Сравнение текущей и старой версии сайта

При возникновении проблем с индексацией важно найти первопричину. Проще всего это сделать при сравнении старой и новой версии сайта. Мы рекомендуем сравнить структуру, контент на ключевых страницах, дизайн, а также код. Возможно, часть обновлений стоит откатить для возврата прежних позиций.

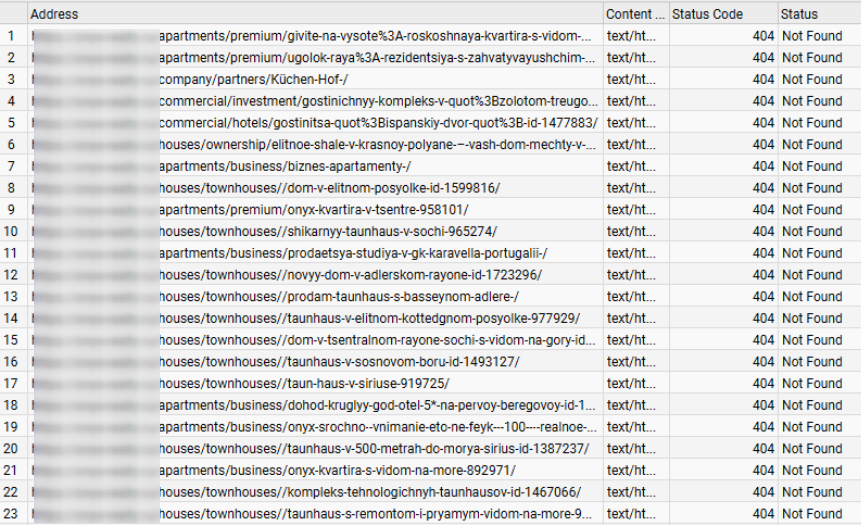

Проверка удаленных страниц и их трафика

Для проведения качественной проверки рекомендуем собрать информацию о страницах в единой таблице. Как это сделать:

- Составить список страниц, приносивших поисковый трафик. Это можно сделать в «Яндекс Метрике». Нужно открыть страницу «Страницы входа» в разделе «Содержание». В отчете указать единственный источник трафика — «Поисковая система».

- Проверить все разделы из списка на код ответа. Нужно искать коды 404, 301, 302. Для этого используют, например, сервисы 4seo.biz, seolium.com, coolakov.ru.

- Выгрузить из «Вебмастера» страницы из индекса со статусом «Удалено: Ошибка HTTP». Для этого следует перейти во вкладку «Статус и URL» —> «Удалено: Ошибка HTTP».

- Объединить информацию в одной таблице.

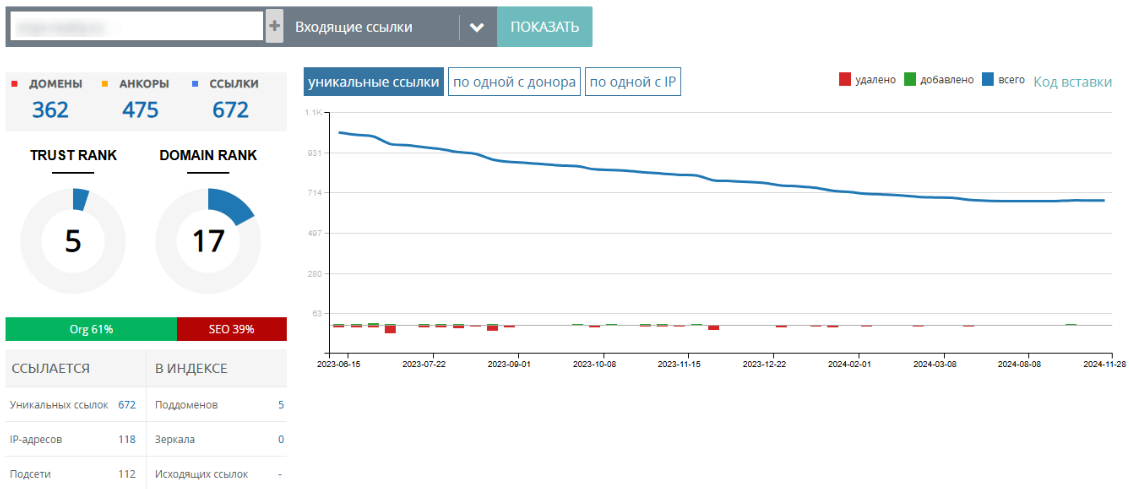

Появились ли проблемы с внешними ссылками?

Внешние ссылки напрямую влияют на позиции сайта в выдаче. Они позволяют не только увеличить трафик на целевые страницы, но и повысить траст. Если вы работаете с ссылочным профилем, то обязательно проверьте его. Возможно, рост массы превышает допустимые показатели, или конкуренты начали накручивать вам ссылки за счет спама.

Проверка профиля ссылок

Для быстрого анализа можно использовать Google Search Console и «Яндекс Вебмастер». Оба сервиса собирают информацию о ссылках.

Однако лучше использовать более мощные инструменты, например, Ahrefs. Этот сервис анализирует каждую ссылку по отдельности, оценивает позиции и траст сайта, а также создает подробные отчеты.

Обнаружение токсичных ссылок и спама

Токсичными называют ссылки с подозрительных и некачественных сайтов, нарушающих правила поисковых систем. Размещение бэклинков на таких ресурсах вредит продвижению. Поэтому вам стоит проверять сайты, на которых публикуются ссылки. В идеале ссылки должны появляться только на трастовых сайтах вашей или смежной тематики.

Если вы обнаружите токсичные ссылки, то стоит воспользоваться инструментом Disavow Links Tool для Google. Для Яндекса придется вручную прописывать атрибут <a href=»» rel=»nofollow» target=»_blank»>текст ссылки</a>.

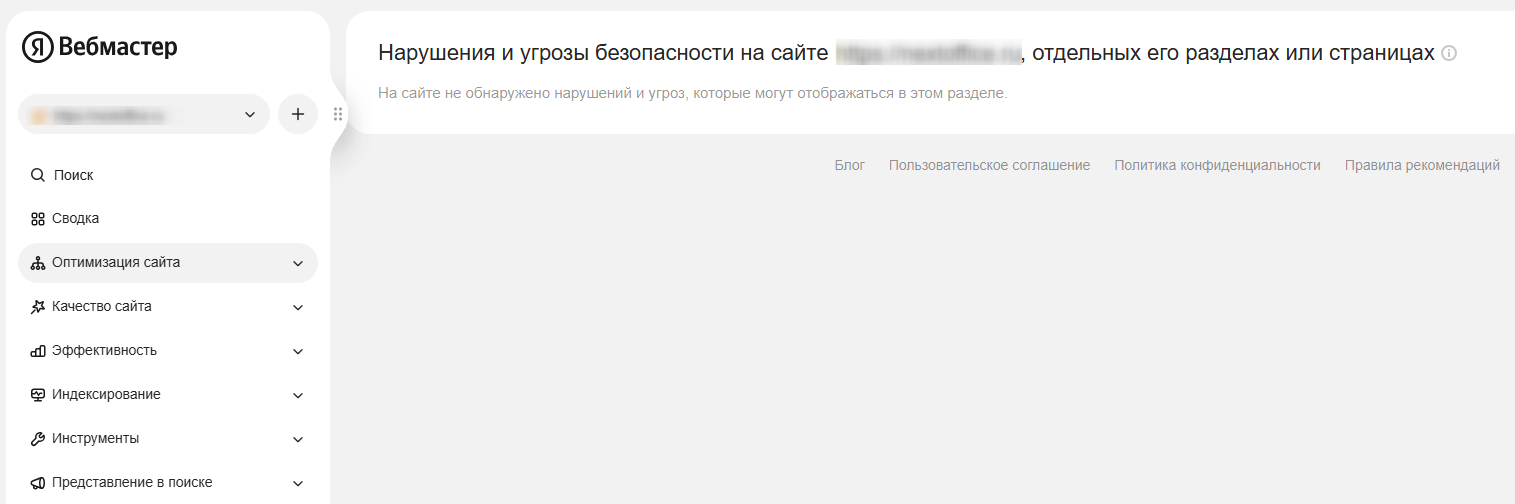

Есть ли санкции или ручные меры от поисковых систем?

Использование запрещенных методов продвижения, неуникального контента и т.д. приводят к применению ручных или автоматических санкций. В таком случае сайт будет искусственно пессимизироваться за нарушение правил.

Где это видно в вебмастерах

Если при проверке самого сайта не удалось понять, в чем заключается проблема, стоит проверить наличие актуальных санкций. Информация о них отображается в консоли вебмастера. Как проверить наличие санкций:

- В Google Search Console. Нужно открыть раздел «Поисковый трафик» и перейти во вкладку «Меры, принятые вручную».

- В «Яндекс Вебмастере». Откройте раздел «Диагностика» и нажмите на «Безопасность и нарушения».

Отметим, что информация о санкциях не всегда отображается в вебмастерах. При этом даже обращение в техподдержку не даст результата. При наличии подозрений на наличие санкций придется прорабатывать все аспекты сайта и регулярно подавать запросы на пересмотр.

Как подавать запрос на пересмотр

После обновления сайта вам стоит написать в техподдержку поисковой системы. Расскажите о наличии подозрений применения санкций и опишите, что именно было изменено. После этого алгоритмы поисковика проанализируют ресурс и при отсутствии нарушений вернут прежние позиции. Вы можете написать в техподдержку Яндекс в разделе «Обратная связь».

Для переиндексации в Google стоит использовать специальный инструмент.

Изменилась ли конкуренция в нише?

Сайты постоянно конкурируют за трафик. Они улучшают контент, расширяют ссылочный профиль, стимулируют повышение поведенческих метрик и т.д. Если ваш сайт не изменился, санкций нет, но позиции упали, возможно, проблема заключается в конкурентах. Для проверки этой гипотезы важно выполнить конкурентный анализ.

Кто поднялся в топ и почему

Мы рекомендуем собрать информацию об основных конкурентах в нише с помощью Compare SERPS. Сервис позволяет сравнить рост и падение позиции в поисковой выдаче за выбранный период.

Собрав статистику, следует изучить сайты по ряду аспектов:

- Структура сайта и юзабилити. Важно проверить, как конкуренты организуют свои сайты, чтобы предоставить пользователям наилучший опыт.

- SEO-оптимизация и ключевые слова. Нужно сравнить, по каким словам ранжируются конкуренты. Это поможет понять, на какие слова следует ориентироваться для своего контента.

- Контентная стратегия. Необходимо изучить, какой контент публикуют конкуренты, в каком формате, какие темы и вопросы обсуждаются. Также важно проанализировать количество и качество публикаций.

- Социальные сети и внешние ссылки. Нужно проверить каналы конкурентов в социальных сетях, количество подписчиков, тип контента, который они делят, и уровень вовлеченности.

- Методы привлечения трафика. Следует узнать, какие каналы используют конкуренты для привлечения трафика, и оценить эффективность каждого из этих каналов.

Сравнительный анализ контента и SEO-стратегии конкурентов

После сбора информации о 3-5 основных конкурентах в нише оцените их стратегии на основе показателей роста позиций. На основе этих сведений вы сможете понять, как следует обновлять свой сайт для возврата позиций.

Упали ли поведенческие метрики?

Поисковые системы постепенно увеличивают значение поведенческих метрик. Поэтому вебмастеры должны поддерживать максимальную вовлеченность аудитории, чтобы позиции сайта росли. Если метрики начинают падать, то потери позиций в выдаче не заставят себя долго ждать.

Показатель отказов, время на сайте, глубина просмотров

Их можно проверить с помощью бесплатных инструментов — «Яндекс Метрика» и Google Analytics. Стоит отметить, что нет единого стандарта, определяющего нормальные показатели. В статье мы приведем лишь приблизительные значения, которые можно считать хорошими:

- Показатель отказов — до 20% с поиска. До 30% с Яндекс Директ

- Время на сайте — 2–3 минуты на информационных сайтах и 1-2 у сервисных ресурсов.

- Глубина просмотра — 2+ страницы.

CTR сниппета в поисковой выдаче

CTR сниппета — это один из поведенческих факторов ранжирования. Чем он выше, тем больше внимания пользователи проявляют к контенту. Это важный сигнал для поисковых систем, поскольку он указывает на полезность и понятность содержания сниппета. Следовательно, страница будет лучше ранжироваться.

Если CTR падает, то позиции также пойдут вниз. Поисковики не удерживают в топе выдачи нерелевантные ответы.

Заключение: как действовать после диагностики

После анализа сайта стоит разработать стратегию SEO-оптимизации сайта. Мы рекомендуем начинать работу с технических проблем и санкций, а затем переходить к обновлению контента, созданию свежих материалов и тестированию методов повышения поведенческих факторов.